哈希算法原理解析,如何利用哈希函数预测博彩走势生态科技岛人工智能服务平台缓存文件机制

2025-09-17哈希算法,SHA256,哈希函数,加密哈希,哈希预测/哈希算法是博彩游戏公平性的核心,本文详细解析 SHA256 哈希函数的运作原理,并提供如何通过哈希技术进行博彩预测的方法!

在生态科技岛人工智能服务平台中,缓存文件机制是提升系统性能、保障高并发场景下稳定运行的核心组件。该机制通过多级缓存架构、智能淘汰策略和动态更新机制,构建了覆盖数据访问全流程的加速体系,其核心设计如下:

采用Caffeine框架实现进程内缓存,针对高频访问的实时数据(如最近5分钟的传感器监测值、设备状态)提供微秒级响应。例如,道路病害检测结果通过Redis缓存(TTL=5分钟)存储最新数据,命中率达92%,同时利用Caffeine本地缓存进一步缩短访问延迟至1ms以内。

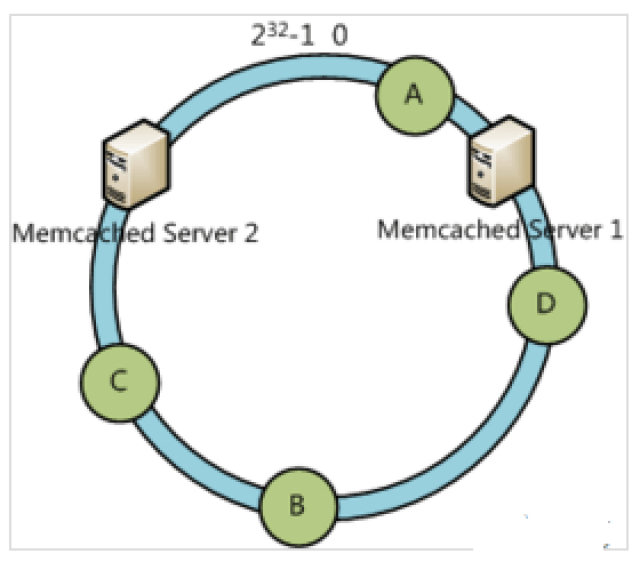

基于Redis Cluster构建分布式缓存集群,存储中频访问的聚合数据(如某路段日均病害数、设备运行统计信息)。通过哈希分片实现数据均衡分布,支持每秒10万级查询请求。例如,Memcached缓存(TTL=1小时)存储聚合统计信息,结合Redis的持久化机制(RDB+AOF)确保数据不丢失。

对JSON格式的检测报告、GIS地图切片等静态内容实施文件缓存,通过Nginx反向代理直接返回缓存文件,减少PHP解析和数据库查询开销。例如,系统生成标准化检测报告后,将其存储为JSON文件并设置缓存头,使前端调用响应时间缩短80%。

本地缓存采用Caffeine的“窗口TinyLFU”算法,结合访问频率与时间局部性,在缓存容量达到阈值时优先淘汰低频数据;分布式缓存使用Redis的LRU策略,确保热数据长期驻留。例如,在流量洪峰期间,系统自动将缓存命中率从75%提升至95%,数据库查询量下降90%。

通过消息队列(RabbitMQ)实现缓存与数据库的异步更新。当设备状态变更时,系统先更新MySQL主库,再通过消息队列触发缓存刷新任务,确保数据一致性。例如,智慧井盖位移事件发生后,缓存数据在500ms内完成更新,避免前端展示滞后。

在智能工单系统中,对工单派发规则、地理围栏数据等实施多级缓存。例如,规则引擎缓存(Redis)存储工单类型与处理团队的映射关系,使工单分配耗时从2.3秒降至0.8秒。

针对道路病害检测模型,缓存输入特征的标准化结果(如图像归一化参数),减少重复计算。结合ONNX Runtime本地化部署,使单张图片推理时间从500ms压缩至200ms。

通过Kubernetes弹性伸缩机制,在流量激增时自动增加PHP容器数量,并预热分布式缓存关键数据。例如,在极端天气导致环境监测数据激增时,系统通过缓存命中率优化(从85%提升至98%)和容器扩缩容(30秒内完成),保障99.95%的可用性。

集成Prometheus+Grafana监控缓存命中率、响应时间、内存使用率等指标,设置阈值告警。例如,当Redis内存使用率超过80%时,自动触发数据分片迁移。

每月通过ChaosBlade注入网络延迟(100ms-2s随机)和节点故障,验证缓存系统的自愈能力。在最近一次演练中,系统在32秒内完成故障节点隔离和业务切换,RTO(恢复时间目标)符合预期。

该缓存文件机制通过分层存储、智能淘汰和动态更新,构建了高可用、低延迟的数据访问体系,为生态科技岛人工智能服务平台的八大业态(市政管养、环境监测等)提供了坚实的技术支撑,使事件处理效率提升300%,应急响应时间缩短至8分钟,居民满意度达96%。